SK하이닉스, CES 2026서 HBM4 16단 48GB 첫 공개…AI 메모리 주도권 강화

- 업계 최고 속도 11.7Gbps 구현한 6세대 HBM4 전면에

- AI 서버·온디바이스·데이터센터 아우르는 메모리 풀라인업 전시

- 커스텀 HBM·PIM·CXL 기반 차세대 AI 시스템 전략 제시

SK하이닉스는 6일(현지시간) 미국 라스베이거스에서 개막한 세계 최대 IT·가전 전시회 ‘CES 2026’에서 6세대 고대역폭메모리(HBM4) 16단 48GB 제품을 세계 최초로 공개하며 차세대 인공지능(AI) 메모리 기술력을 선보였다.

이번에 공개된 HBM4 16단 48GB는 업계 최고 수준인 11.7Gbps의 속도를 구현한 제품으로, 기존 HBM4 12단 36GB의 후속 모델이다. SK하이닉스는 고객사의 개발 일정에 맞춰 제품 개발이 순조롭게 진행되고 있다고 설명했다. AI 연산량 급증과 함께 고성능·고용량 메모리에 대한 수요가 빠르게 확대되는 가운데, HBM4는 차세대 AI 서버와 가속기 시장의 핵심 메모리로 주목받고 있다.

이번 CES 전시에서는 올해 HBM 시장의 주력 제품으로 꼽히는 5세대 HBM3E 12단 36GB도 함께 선보인다. 해당 제품이 탑재된 글로벌 고객사의 최신 AI 서버용 GPU 모듈을 함께 전시해, 실제 AI 시스템 내에서의 역할과 성능 경쟁력을 직관적으로 제시했다.

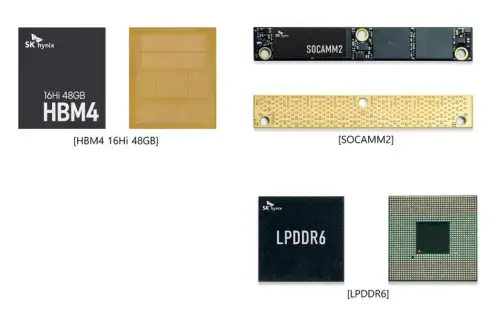

SK하이닉스는 HBM 외에도 AI 서버 특화 저전력 메모리 모듈인 2세대 소캠(SOCAMM2)을 공개하며, 폭증하는 AI 서버 수요에 대응하는 메모리 포트폴리오를 강화했다. 온디바이스 AI 구현을 겨냥한 차세대 저전력 D램 규격 LPDDR6 역시 전시돼, 데이터 처리 속도와 전력 효율을 동시에 개선한 기술 경쟁력을 강조했다.

낸드플래시 부문에서는 AI 데이터센터 구축 확대로 수요가 급증하고 있는 초고용량 eSSD에 최적화된 321단 2테라비트 QLC 낸드 제품을 선보였다. 현존 최대 수준의 집적도를 구현한 이 제품은 이전 세대 대비 전력 효율과 성능을 크게 향상시켜, 저전력이 요구되는 AI 데이터센터 환경에서 강점을 갖는다.

현장에는 AI 시스템용 메모리 솔루션이 하나의 생태계로 유기적으로 연결되는 과정을 보여주는 ‘AI 시스템 데모존’도 마련됐다. 고객 맞춤형 커스텀 HBM, PIM 반도체 기반 AI 가속기 카드 AiMX, 메모리 내 연산 기술 CuD, 연산 기능을 통합한 CXL 메모리 CMM-Ax, 데이터 인식형 스토리지 CSD 등 차세대 기술이 전시와 시연을 통해 소개됐다. 특히 커스텀 HBM의 내부 구조를 시각화한 대형 전시물은, AI 연산 효율과 비용 최적화를 위해 메모리 내부로 연산 기능을 통합하는 새로운 설계 방향을 직관적으로 보여줬다.

김주선 SK하이닉스 AI 인프라 사장은 “AI가 촉발한 혁신이 가속화되면서 고객의 기술적 요구 역시 빠르게 진화하고 있다”며 “차별화된 메모리 솔루션과 고객과의 긴밀한 협업을 통해 AI 생태계 전반에서 새로운 가치를 지속적으로 창출해 나가겠다”고 말했다.

더 좋은 미래를 위한 콘텐츠 플랫폼 – <굿퓨처데일리>